Fundamentos de IA Generativa

A IA Generativa é um ramo da inteligência artificial focado em criar coisas novas — textos, imagens, músicas, vídeos, código e muito mais. Diferente de sistemas tradicionais que apenas classificam ou reconhecem padrões, os modelos generativos “aprendem” as características dos dados que estudaram e conseguem inventar exemplos inéditos que parecem reais. Por comparação, modelos discriminativos são voltados para prever ou classificar algo a partir dos dados existentes (por exemplo, identificar se uma imagem contém um gato ou um cachorro).

História e Evolução

O ponto de partida costuma ser lembrado com ELIZA, o chatbot criado por Joseph Weizenbaum em 1966, que simulava conversas simples e abriu caminho para o imaginário sobre máquinas que “falam”. Nas décadas seguintes, técnicas como os Hidden Markov Models (HMMs) e as Misturas Gaussianas foram usadas para gerar sequências e sons, especialmente em reconhecimento e síntese de fala.

O salto veio no início dos anos 2010 com as redes neurais profundas, que, impulsionadas pelo poder de processamento das GPUs, ampliaram radicalmente as capacidades da IA. Em 2014, Ian Goodfellow apresentou as GANs (Generative Adversarial Networks), inaugurando uma nova era de geração realista de imagens, logo acompanhada pelos VAEs (Variational Autoencoders) e, mais recentemente, pelos modelos de difusão, hoje muito usados em imagens e vídeos.

Um divisor de águas foi a arquitetura Transformer (2017), que revolucionou a área ao permitir processar sequências em paralelo de forma eficiente — o fundamento que possibilitou modelos de linguagem de larga escala, como os atuais LLMs.

- Fale com a Eliza

- Vídeo: A História da IA

- O que são Redes Neurais Artificiais Profundas?

- Introdução às Redes Adversárias Generativas (GANs)

- O que é GPU?

- Por que as GPUs são Ideais para IA?

- Tudo o que você precisa saber sobre LLM (Large Language Model)

Modelos Discriminativos vs. Generativos

Os modelos generativos aprendem a P(X, Y), isto é, como os dados e seus rótulos se distribuem em conjunto. Isso permite não apenas classificar, mas também gerar novos exemplos que se parecem com os dados originais. Alguns exemplos:

- Naive Bayes — método probabilístico simples, muito usado em classificação de texto e filtragem de spam.

- Hidden Markov Models (HMMs) — aplicados em fala, bioinformática e séries temporais.

- GANs (Generative Adversarial Networks) — introduzidas por Ian Goodfellow em 2014, revolucionaram a geração de imagens realistas.

- VAEs (Variational Autoencoders) — técnica que combina aprendizado profundo com inferência bayesiana para gerar novos dados.

Já os modelos discriminativos aprendem a P(Y|X), ou seja, a probabilidade de um rótulo Y dado os dados X. Eles tendem a ser mais simples e eficientes para tarefas preditivas, mas não criam novos exemplos. Exemplos clássicos:

- Regressão Logística — usada para prever probabilidades binárias, como “sim/não”.

- SVMs (Support Vector Machines) — classificadores robustos que buscam hiperplanos de separação ótima.

- Redes Neurais Profundas — base do deep learning, aplicadas em visão computacional, NLP e recomendação.

Arquiteturas-base

- GANs (Generative Adversarial Networks): usam dois modelos (gerador e discriminador) em um jogo de soma zero para gerar dados realistas.

- VAEs (Variational Autoencoders): codificam os dados em um espaço latente contínuo e aprendem a decodificá-los de volta, otimizando reconstrução e regularização.

- Modelos de difusão: geram amostras removendo ruído gradualmente de um vetor aleatório, simulando um processo inverso de difusão.

- Transformers: utilizam o mecanismo de autoatenção para capturar dependências de longo alcance sem recorrência.

Tokenização, Autoatenção e Codificação Posicional

O primeiro passo de um pipeline de NLP é dividir o texto em tokens (palavras, subpalavras ou caracteres) e convertê-los em números. Esse processo de tokenização transforma dados não estruturados em estruturas manipuláveis e pode ocorrer em diferentes níveis (sentenças, palavras, subpalavras) usando ferramentas como NLTK e spaCy.

Em seguida, o mecanismo de autoatenção (Artigo: Attention Is All You Need) permite que cada token "preste atenção" aos demais, ajustando seus pesos conforme o contexto e capturando relações de longo alcance. Como a autoatenção é invariante a permutações, modelos Transformers utilizam codificação posicional para incorporar a ordem das palavras. A codificação deve ser única, seguir relações lineares e generalizar para sequências maiores. Veja um exemplo do funcionamento.

- The Tokenizer Playground (Contagem de tokens)

- OpenAI GPT API Pricing Calculator (Valores de tokens)

Exemplos e Aplicações

Modelos generativos já produzem imagens (ex. DALL·E 3, Midjourney, Gemini, Image FX), músicas (Jukebox, Magenta, SUNO), textos e códigos. Eles são usados em prototipagem de produtos, design de interfaces, geração de arte, criação de conteúdos educacionais e até na descoberta de moléculas na indústria farmacêutica.

Exemplos de geradores de texto:

Exemplos de aplicações que desenvolvem / codificam:

Grandes Modelos de Linguagem (LLMs)

LLMs são redes neurais com bilhões de parâmetros treinadas em grandes corpora para prever a próxima palavra e gerar texto coerente. Eles aprendem representações semânticas profundas e permitem resolver tarefas de tradução, resumo, programação e até raciocínio. Exemplos populares incluem GPT‑5, Claude 4, Gemini, DeepSeek, Grok, LLaMA 3, Mistral e Command R.

Parâmetros de Geração

Ao usar APIs de LLMs, podemos ajustar hiperparâmetros que controlam a criatividade e a diversidade das saídas. A temperatura amplifica ou reduz a aleatoriedade da distribuição: valores altos geram textos mais criativos, enquanto valores baixos produzem saídas mais conservadoras. O top‑k limita o número de tokens com maior probabilidade a serem amostrados, enquanto o top‑p (nucleus sampling) seleciona tokens cumulativamente até atingir uma probabilidade somada, permitindo flexibilidade na seleção dos candidatos.

| Hiperparâmetro | Função | Impacto |

|---|---|---|

| Temperatura | Escala a distribuição de probabilidade | Alta → criativo / Baixa → preciso |

| Top‑k | Limita escolha aos k tokens mais prováveis | Reduz aleatoriedade |

| Top‑p | Seleciona tokens até atingir probabilidade acumulada p | Balanceia diversidade e controle |

| Presença/Frequência | Penaliza repetição de palavras | Estimula vocabulário variado |

Métricas de Avaliação

A qualidade dos textos gerados pode ser medida por:

| Métrica | Descrição | Fonte |

|---|---|---|

| Perplexidade | Exponenciação da média da log-verossimilhança negativa; mede quão provável o modelo considera o texto. | Hugging Face |

| BLEU | Mede a sobreposição de n-gramas entre a saída e uma tradução de referência, muito usado em tradução automática. | ModernMT |

| ROUGE | Calcula a sobreposição de n-gramas e citações entre o texto gerado e o alvo, utilizado em sumarização. | Galileo |

| METEOR | Leva em conta sinônimos, flexões e ordem para aproximar melhor o julgamento humano. | Dataforest |

| BERTScore | Usa embeddings contextualizados de BERT e calcula similaridade cosseno entre palavras, correlacionando bem com avaliações humanas. | Hugging Face |

Confira: Mais sobre avaliações de modelos, prompts e etc

Modelos Abertos vs. Proprietários

Modelos open‑source disponibilizam o código e os pesos, reduzindo custos de licença e facilitando a customização. Eles fomentam inovação rápida e transparente. Já os modelos proprietários oferecem desempenho superior em aplicações especializadas, implementações mais simples e serviços de segurança integrados. Ao selecionar um modelo, considere custo total, necessidade de personalização, privacidade e suporte.

- Principais LLM´s do mercado e API´s

Exemplos e Casos de Uso

Chatbots como ChatGPT auxiliam no atendimento ao cliente, geram resumos e respondem perguntas sobre documentos. Ferramentas como GitHub Copilot ajudam programadores a escrever código. Escritórios de advocacia utilizam LLMs para resumir processos e sugerir cláusulas, enquanto empresas de mídia automatizam títulos e descrições. Ajustar hiperparâmetros como temperatura e top‑p permite controlar criatividade, garantindo respostas formais ou criativas conforme necessidade.

Ao integrar LLMs com APIs, é possível construir assistentes em sites, apps ou bots. É comum usar OpenAI para gerar respostas, Cohere ou Anthropic para tarefas específicas e Hugging Face para modelos open‑source.

Rodando uma LLM local

Executar uma LLM no seu próprio hardware dá controle total de dados, latência baixa e custos previsíveis. É ideal para prototipagem, POCs offline e workloads com dados sensíveis. Em contrapartida, exige GPU/CPU adequadas, curadoria de modelos e manutenção do ambiente.

- GPU com 8–24 GB de VRAM (ou CPU potente + quantização 4/5-bit).

- Espaço em disco para modelos (3–30 GB por checkpoint, dependendo do tamanho).

- SO atualizado e drivers da GPU (CUDA/cuDNN para NVIDIA ou equivalentes AMD/Apple).

Ollama (rápido & simples)

Ideal para rodar localmente e expor uma API HTTP com poucos comandos.

# Instalação (Linux/Mac) – veja docs do Windows

curl -fsSL https://ollama.com/install.sh | sh

# Baixar e rodar um modelo

ollama run llama3.1

# Servir via API local (porta 11434)

# POST http://localhost:11434/api/generate

llama3.1, mistral, qwen, phi…

vLLM (alto throughput)

Focado em produção e muitas requisições simultâneas (PagedAttention).

# Instalação

pip install vllm

# Servindo um modelo (OpenAI-compatible)

python -m vllm.entrypoints.openai.api_server \

--model meta-llama/Llama-3.1-8B-Instruct \

--tensor-parallel-size 1

# Endpoint: http://localhost:8000/v1/chat/completions

LM Studio / text-gen-webui

Interfaces gráficas para baixar, testar e fazer chat/embedding local sem terminal.

- Download de modelos do Hugging Face com 1 clique.

- Suporte a quantizações (GGUF, GPTQ).

- Plugins, perfis e logs de performance.

- Escolha do modelo: balanceie tamanho (7–8B, 13B, 70B) vs. VRAM disponível e qualidade.

- Quantização: use GGUF 4-bit para reduzir memória com pouca perda de qualidade.

- Segurança: mantenha a API local atrás de proxy/autenticação; isole redes em produção.

- Observabilidade: registre latência, uso de VRAM e tokens/s para dimensionar bem.

– Ollama vs vLLM - Performance ⚡ vs Praticidade 🧰

– Catálogo de modelos no Ollama

– Servidor OpenAI-compatible do vLLM

– LM Studio (GUI) · text-generation-webui

– Modelos no Hugging Face

– Performance vs Praticidade: uma comparação entre vLLM e Ollama

Dica rápida: para aplicações de negócio, use Ollama para POCs rápidas e vLLM quando precisar de alta concorrência e compatibilidade com SDKs OpenAI-like.

Model Context Protocol (MCP)

O Model Context Protocol (MCP) é um padrão aberto que estrutura a interação entre aplicações de IA e fontes externas. Ele permite que agentes acessem ferramentas e dados como repositórios GitHub, planilhas Google, e bases de conhecimento de forma interoperável.

Componentes

- Instructions: definem o comportamento desejado do modelo.

- Tools: APIs ou funções externas que o modelo pode invocar.

- Documents: arquivos ou textos usados como contexto.

- Examples: demonstrações de uso corretos.

- History: registro das interações passadas.

- Hyperparameters: configurações (temperatura, top‑p, etc.).

Aplicações

MCP é essencial em sistemas multiagente, arquiteturas RAG e pipelines corporativos pois padroniza o fornecimento de contexto, garantindo clareza semântica e reuso entre aplicações. Ao conectar‑se a serviços como GitHub ou Google Drive, o modelo acessa dados reais e executa ações com segurança.

Exemplo Prático

Imagine um assistente de código que precisa analisar um repositório no GitHub e uma planilha no Google Sheets. Utilizando MCP, o desenvolvedor registra essas fontes como documentos e ferramentas. O LLM então recupera o código, usa uma função de planilha para obter dados, combina as informações e responde de forma estruturada. Esse padrão simplifica a criação de sistemas de suporte internos e pipelines de geração de relatórios.

Ética, Segurança e Sustentabilidade

Vieses e Discriminação

Modelos generativos aprendem padrões de grandes conjuntos de dados, que podem refletir preconceitos sociais. É essencial monitorar e mitigar vieses, ajustando dados de treinamento e aplicando técnicas como calibragem de saídas e filtros de segurança. A transparência na documentação e auditoria dos dados é crucial.

Alucinações e Mitigação

Alucinações ocorrem quando o modelo gera informações plausíveis, porém falsas. Estratégias de mitigação incluem a checagem de fatos com RAG, a limitação de respostas a dados conhecidos e a revisão humana em aplicações críticas.

Privacidade e Regulamentação

No Brasil, a LGPD (Lei Geral de Proteção de Dados) entrou em vigor em 18 de setembro de 2020. Ela regula o tratamento de dados pessoais, assegurando princípios como propósito, necessidade, transparência e segurança. A lei garante que indivíduos possam acessar, corrigir ou excluir seus dados. Na União Europeia, o AI Act classifica sistemas de IA por risco e proíbe usos como manipulação de grupos vulneráveis e vigilância biométrica em tempo real. Modelos generativos devem divulgar conteúdo gerado, prevenir conteúdo ilegal e publicar sumários de dados de treinamento.

Sustentabilidade Computacional

Treinar modelos gigantescos consome enormes quantidades de energia e água. Estima‑se que o treinamento do GPT‑3 gastou cerca de 1.287 MWh, emitindo 552 toneladas de CO₂. Data centers para IA consomem cada vez mais eletricidade e necessitam de água para resfriamento, impactando ecossistemas. Práticas sustentáveis incluem otimizar arquiteturas, usar energia renovável e reutilizar calor.

Exemplos de Uso e Mitigação

Em recrutamento, LLMs podem analisar currículos, mas devem ser calibrados para evitar vieses de gênero ou raça. Ferramentas como AI Fairness 360 ajudam a auditar e mitigar preconceitos. Em saúde, modelos auxiliam no diagnóstico, porém os resultados precisam ser revisados por especialistas para prevenir decisões erradas. Para privacidade, empresas anonimizam dados e aplicam criptografia. O uso de RAG e a verificação por fontes confiáveis minimizam alucinações.

Engenharia de Prompts / Contexto

Técnicas

- Zero‑shot: o modelo executa uma tarefa sem exemplos específicos, baseando-se apenas no conhecimento prévio.

- Few‑shot: fornece alguns exemplos para guiar a resposta e melhorar a precisão.

- Chain of Thought (CoT): solicita que o modelo explicite seu raciocínio passo a passo.

- ReAct: combina raciocínio com chamadas a ferramentas para buscar informações.

- Tree of Thoughts (ToT): divide o problema em ramificações e permite explorar várias soluções.

Práticas Recomendadas

Para obter boas respostas: seja claro e específico, forneça contexto e formate a saída desejada. Inclua exemplos quando necessário e defina limites (tamanho, estilo). O prompt tuning cria "tokens suaves" treináveis que orientam o modelo sem alterar seus pesos internos, enquanto o fine‑tuning ajusta os parâmetros do modelo em um novo conjunto de dados. Escolha fine‑tuning quando precisar de domínio especializado e consistência em larga escala; use prompt engineering para protótipos rápidos com menos dados.

Ferramentas

Bibliotecas como LangChain oferecem templates de prompts reusáveis. Plataformas como PromptLayer e PromptFoo registram experimentos e ajudam a avaliar respostas. Estas ferramentas permitem iterar e rastrear melhorias sistematicamente.

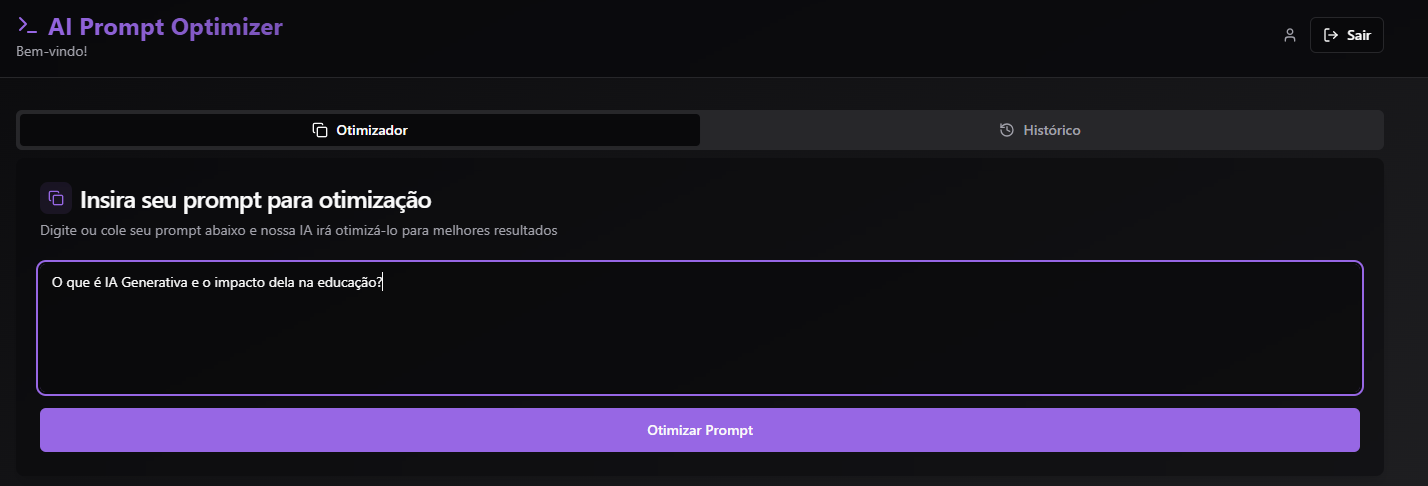

AI Prompt Optimizer: ferramenta para otimizar e ajustar prompts com base em técnicas e dicas de prompt. Teste já a aplicação, é gratuita! Se cadastre e mantenha todo seu histórico de otimização de prompt.

Além de lhe passar um prompt otimizado com base em sua necessidade, o AI Prompt Optimizer lhe oferece dicas e o que fez para otimizar seu prompt de forma detalhada.

Exemplos Práticos de Prompts

- Zero‑shot: "Resuma o artigo a seguir em uma frase formal: [texto]"

- Few‑shot: forneça 2‑3 exemplos antes da pergunta para orientar o estilo, por exemplo: "Exemplo 1: Pergunta … Resposta …"

- Chain of Thought: "Explique passo a passo como calcular a mediana de uma lista."

- ReAct: combine raciocínio e chamadas a APIs: "Use a função

search()para encontrar a data e explique‑a." - Tree of Thoughts: peça ao modelo para listar alternativas ("Liste três ideias de marketing distintas, analise cada uma e escolha a melhor.").

- Auto-Prompting (Self-Prompting): A ideia é simples: em vez de você escrever diretamente o prompt final, você pede para a própria LLM gerar o prompt ideal que seria usado para resolver a tarefa.

APIs e Integrações com LLMs

Para integrar LLMs em aplicativos, é preciso autenticar-se junto ao provedor (OpenAI, Cohere, Anthropic, Hugging Face, Mistral, Gemini) e enviar solicitações via HTTP. Ajuste hiperparâmetros e gerencie o uso de tokens para controlar custos e desempenho.

Exemplo em Python (OpenAI)

import openai

openai.api_key = "<sua-chave>"

resp = openai.ChatCompletion.create(

model="gpt-4o",

messages=[{"role": "user", "content": "Explique IA generativa"}],

temperature=0.5,

max_tokens=200

)

print(resp.choices[0].message.content)Exemplo em JavaScript (fetch)

async function chamarLLM(prompt) {

const resp = await fetch('https://api.openai.com/v1/chat/completions', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer <sua-chave>'

},

body: JSON.stringify({

model: 'gpt-4o',

messages: [{ role: 'user', content: prompt }],

temperature: 0.7

})

});

const data = await resp.json();

console.log(data.choices[0].message.content);

}Casos de Integração

Construa um chatbot de atendimento que utiliza n8n para orquestrar um fluxo: um webhook recebe a solicitação, chama a API da OpenAI ou Cohere, e grava a resposta em uma planilha do Google Sheets. Plataformas como Make.com, Zapier e Pipedream oferecem conectores para integrar LLMs a CRMs e bancos de dados.

Embeddings e Vetorização

Embeddings são representações vetoriais densas que capturam relações semânticas e sintáticas. Diferentemente de one‑hot, que usa vetores esparsos, embeddings posicionam termos semelhantes próximos no espaço. Abordagens como Word2Vec, GloVe, BERT e SBERT são usadas para palavras e sentenças. Um embedding é uma representação matemática que ajuda a capturar relações semânticas.

Tipos e Ferramentas

- Word2Vec: aprende embeddings usando Skip‑gram ou CBOW.

- GloVe: utiliza coocorrência global para mapear palavras.

- BERT/SBERT: gera embeddings contextualizados por atenção.

- Embeddings proprietários: OpenAI (text-embedding-3-small) e Cohere (embed-english-v3).

Bancos de Dados Vetoriais

VectorDBs armazenam embeddings e possibilitam buscas por similaridade com alta performance. Eles suportam operações CRUD, filtragem por metadados e escalabilidade horizontal. Exemplos: FAISS (biblioteca de índice), Pinecone, Chroma e Weaviate.

Visualização

Reduções de dimensionalidade como t‑SNE e PCA projetam embeddings para 2D/3D, facilitando a inspeção de clusters e relações.

Exemplos de Aplicação

Empresas de e‑commerce utilizam embeddings para recomendação: ao consultar um produto, o sistema busca itens similares em um vectorDB como Pinecone, Chroma ou Weaviate. Motores de busca interna aplicam FAISS para indexar milhões de documentos. Startups também combinam embeddings de OpenAI ou Cohere com clustering para segmentar usuários.

- ⚙️ Classificação de texto

RAG — Retrieval-Augmented Generation

O RAG combina recuperação de documentos com geração para fornecer respostas atuais e específicas. A arquitetura consiste em (1) chunking e vetorização de documentos, (2) indexação em um vectorDB, (3) busca de trechos relevantes e (4) geração condicionada com base nos trechos recuperados. Essa abordagem reduz alucinações e permite atualizar o modelo sem re-treinamento extenso.

Frameworks

- LangChain: abstrai pipelines de RAG com módulos de prompt, repositórios de documentos e agentes.

- LlamaIndex: otimizado para indexação e recuperação em bancos de dados variados.

- Haystack: suporta pipelines customizáveis e integração com ElasticSearch e FAISS.

Avaliação

Métricas-chave incluem precisão e recall (quão relevantes são os documentos recuperados), latência (tempo de resposta) e detecção de alucinações. Ajuste o tamanho dos chunks, número de documentos retornados e parâmetros de geração para otimizar esses indicadores.

Casos de Uso

No setor jurídico, um assistente LLM recupera cláusulas específicas usando LangChain e LlamaIndex, busca trechos em um vectorDB (Pinecone ou Weaviate) e gera uma redação contextualizada. Em saúde, RAG combina prontuários estruturados com notas médicas para oferecer recomendações personalizadas.

- Pipeline RAG para Análise de Documentos PDF

- RAG - Retrieval-Augmented Generation (Completo)

Finetuning e Treinamento de Modelos

Customizar um LLM pode ser feito por diferentes técnicas:

- Fine‑tuning: ajusta todos ou grande parte dos parâmetros em um novo dataset, obtendo excelente adaptação, mas com custo computacional elevado.

- LoRA (Low‑Rank Adaptation): congela pesos originais e aprende atualizações por decomposição de baixa dimensão, exigindo menos memória.

- Prompt Tuning: treina um pequeno conjunto de tokens aprendíveis que são concatenados ao prompt, sem alterar os pesos da rede.

- QLoRA: aplica quantização (8‑bit/4‑bit) e LoRA simultaneamente, tornando o treinamento de grandes modelos mais acessível.

Frameworks

Use Hugging Face Transformers e a biblioteca PEFT para LoRA, além de projetos como Axolotl e DeepSpeed para treinar modelos de forma distribuída. Datasets como OpenOrca, Dolly e UltraChat fornecem corpora de instruções para fine‑tuning.

Riscos, Custos e Compliance

Finetuning envolve desafios: custo de hardware, risco de vazamento de dados sensíveis e necessidade de conformidade regulatória. Avalie se prompt engineering ou LoRA atendem à sua aplicação antes de partir para um treinamento completo.

Exemplos

Um suporte ao cliente pode ser melhorado treinando um LLM com FAQs da empresa usando a biblioteca Transformers, aplicando PEFT com LoRA para economizar memória. Projetos como Axolotl e DeepSpeed facilitam treino distribuído.

- ⚙️ Fine Tuning

Agentes Autônomos Inteligentes

Agentes de IA podem planejar, executar tarefas e colaborar. Ao combinar LLMs com ferramentas externas, eles se tornam capazes de realizar fluxos de trabalho complexos. Bibliotecas como CrewAI, LangGraph, AutoGen e SuperAgent facilitam a criação desses sistemas multiatores.

Raciocínio Encadeado

Métodos como ReAct, Reflexion e Self‑Ask estruturam o raciocínio em etapas, alternando geração e busca de informações. Os agentes podem manter memórias de curto e longo prazo, compartilhar contextos e usar ferramentas como navegadores ou bases de dados.

Boas Práticas de Governança

Defina papéis e objetivos claros para cada agente, use backstories e ferramentas adequadas, limite o número de passos e implemente guardrails para lidar com erros e alucinações.

Exemplos de Sistemas Multiagentes

Para planejar uma viagem, um agente planejador de itinerário consulta blogs de viagens, outro verifica preços em sites de passagens e hotéis, e um terceiro cria um resumo com recomendações; eles cooperam via CrewAI ou LangGraph. Outra aplicação é automatizar campanhas de marketing: agentes geram listas de leads, escrevem e‑mails personalizados e monitoram métricas.

- Projeto Multi Agente - Concessionária

- GPT Personalizado (OpenAI)

- 500 AI Agents Projects

Plataformas No-Code e Low-Code

As plataformas No-Code e Low-Code permitem criar automações, integrações e até aplicações completas sem a necessidade de programação avançada. Elas são ideais para conectar LLMs (Large Language Models) a planilhas, CRMs, bancos de dados, ferramentas de comunicação e muito mais, reduzindo tempo de desenvolvimento e custo de implementação.

Ferramentas como n8n, Make.com, Zapier e Pipedream oferecem conectores prontos, fluxos visuais e integração direta com APIs, possibilitando a criação de soluções inteligentes em minutos. Um exemplo simples: receber uma solicitação de análise de texto, processar em um LLM e gravar o resultado automaticamente em uma planilha do Google Sheets.

Exemplos de Aplicações Práticas

- n8n: Crie um fluxo que lê dados de uma planilha do Google Sheets, envia para a API de um LLM para classificação de sentimentos e encaminha os resultados para um canal do Slack ou para um CRM como HubSpot.

- Make.com: Automatize a geração de posts para redes sociais. Exemplo: um texto é enviado para o LLM, que cria a legenda e gera uma imagem com DALL·E; o Make.com agenda a publicação automática no Instagram ou LinkedIn.

- Zapier: Configure um fluxo em que cada novo lead no Google Forms é automaticamente enriquecido com dados via LLM (ex.: normalização de nome, categorização de interesse) e gravado no Salesforce ou Pipedrive.

- Pipedream: Monte um endpoint serverless que recebe mensagens de um chatbot, consulta um LLM para gerar a resposta e envia de volta ao usuário. Ideal para conectar serviços como Stripe (pagamentos) ou Salesforce (atendimento).

Onde usar na prática?

Essas ferramentas são muito utilizadas em cenários de:

- Marketing: criação automática de campanhas, geração de conteúdo e agendamento de posts.

- Vendas: integração de leads entre formulários, CRMs e e-mails, com enriquecimento via LLM.

- Atendimento: chatbots inteligentes conectados a bancos de dados e sistemas de suporte.

- Operações: relatórios automatizados a partir de dados em planilhas ou bancos.

- Educação: correção automática de respostas abertas, criação de feedbacks personalizados.

Em resumo, plataformas No-Code e Low-Code democratizam o uso da IA Generativa, permitindo que profissionais de qualquer área construam soluções personalizadas sem depender totalmente de equipes de TI.

Plataformas Assistidas por IA e Low-Code

Além das ferramentas de automação no-code, surgem também ambientes que aceleram a criação de aplicações e o desenvolvimento de software com auxílio de IA. Plataformas como Lovable e Cursor permitem prototipar soluções e escrever código de forma mais rápida e inteligente, combinando a simplicidade do low-code com a inteligência dos LLMs.

Exemplos de Aplicações

Com o Lovable, é possível criar aplicações completas a partir de descrições em linguagem natural, integrando APIs e bancos de dados em minutos. Já o Cursor funciona como um IDE inteligente, que sugere, corrige e acelera a escrita de código em linguagens como Python, JavaScript e SQL, reduzindo a complexidade de projetos de software. Outras ferramentas semelhantes incluem o Replit, que combina editor online com IA para colaboração em tempo real, e o CodeSandbox, voltado para prototipagem rápida de aplicações web.

Vibe Coding: o que é e por que há polêmica

Vibe coding é desenvolver descrevendo o objetivo em linguagem natural e deixando a IA gerar e ajustar o código. O ponto polêmico: muita gente pratica sem ler o código gerado, focando só no comportamento observado. Isso acelera protótipos, mas pode gerar incidentes sérios quando levado à produção sem guard-rails.

Como funciona na prática

- Prompt → Código: você descreve “o que o sistema deve fazer”. A IA gera o esqueleto/feature.

- Teste conversacional: você executa, dá feedback (“erros”, “melhorar X”), e a IA refatora.

- Loop rápido: repete até “funcionar”. O risco nasce quando ninguém revisa o código ou as permissões.

Onde faz sentido

- POCs, hackathons e protótipos descartáveis.

- Exploração de APIs/SDKs e geração de boilerplate.

- Automação interna de baixo risco e sem dados sensíveis.

Benefícios

- Velocidade de ideação → MVP.

- Redução de barreiras para não-devs (supervisionado).

- Time foca mais em requisitos, UX e arquitetura.

Riscos

- Sem revisão → bugs e vulnerabilidades passam.

- Agentes com privilégios excessivos podem apagar dados ou implantar código ruim.

- Confusão: “programar com IA” ≠ “vibe coding”.

Boas práticas (para não virar manchete)

- Separação de ambientes (dev/test/prod) e princípio do menor privilégio nas credenciais da IA.

- Approval gates: PRs, code review humano e testes automatizados antes de qualquer deploy.

- Observabilidade e trilhas: logs de ações do agente, prompts, diffs e auditoria.

- Direito de reversão: backup frequente, restore rápido, feature flags e rollback.

Stack sugerida para “vibe com segurança”

- IDE/Assistentes: Cursor, GitHub Copilot, Codeium (geração/refatoração com contexto de projeto).

- Automação: n8n, Make.com, Zapier, Pipedream (orquestram chamadas a LLMs e serviços).

- Controle: Git + CI/CD (lint, testes, SAST), cofre de segredos e RBAC no provedor cloud.

Quando evitar

Sistemas regulados, dados sensíveis, SLAs críticos e qualquer ambiente sem esteiras de testes, revisão e rollback maduras.

Data Lake e Governança de Dados

Um Data Lake é um repositório centralizado que armazena grandes volumes de dados estruturados, semiestruturados e não estruturados sem esquema predefinido, permitindo flexibilidade para experimentação e análise. A abordagem schema‑on‑read adia a definição do esquema para o momento da consulta.

O Data Lakehouse combina a flexibilidade do lake com a governança e transacionalidade de um data warehouse, oferecendo plataforma unificada para armazenar e processar dados diversos. Ele suporta ACID e controle de versionamento, facilitando machine learning e BI.

Governança

Práticas de governança abrangem controle de acesso (RBAC/ABAC), criptografia, rastreamento de lineage e auditoria. A conformidade com LGPD e outras regulamentações exige registrar consentimento, monitorar uso de dados e implementar anonimização quando necessário.

Exemplos de Implementação

Um laboratório de pesquisa armazena dados brutos em Amazon S3 e usa Databricks para processar e governar o Data Lakehouse. Empresas de streaming armazenam logs em camadas Bronze/Prata/Ouro, aplicando RBAC com Unity Catalog e auditando lineage com ferramentas de observabilidade.

Comparações

Explore tabelas comparativas entre os modelos mais recentes de IA generativa, APIs de acesso, embeddings e bancos vetoriais. Dados atualizados para 2025.

Modelos (LLMs)

| Modelo | Destaque | Contexto (máx.) | Latência típica | Casos de uso | Docs |

|---|---|---|---|---|---|

| GPT-5 (OpenAI) | Multimodal + raciocínio dinâmico | até 196k tokens (Thinking) | baixa–média | assistentes gerais, análise profunda, RAG | Docs |

| Claude 4 (Anthropic) | Planejamento + memória de longo prazo | alto (Opus 4.1) | média | raciocínio complexo, suporte, resumo longo | Docs |

| Gemini 2.5 (Google) | Raciocínio multimodal (“thinking models”) | muito alto | baixa (Flash-Lite) | documentos longos, multimodalidade, apps móveis | Docs |

| Mistral Large | Custo-benefício, open-source | alto | baixa–média | apps produtivos, servidores próprios | Docs |

| Llama 3.1 (Meta) | Open-source flexível | médio–alto | depende do host | on-premise, customização | Docs |

Provedores de API

| Provedor | Modelos | Recursos | Preço | Limites | Docs |

|---|---|---|---|---|---|

| OpenAI | GPT-5, GPT-4o, embeddings | function calling, batch, streaming | por token | rate limits por conta | Docs |

| Anthropic | Claude 4.x | tool use, raciocínio avançado | por token | limites por tier | Docs |

| Google AI | Gemini 2.5 | multimodal, raciocínio | por token | limites por projeto | Docs |

| Mistral | Large, Small, Codestral | serverless/OSS | por token | limites por chave | Docs |

| Hugging Face | OSS variados | endpoints gerenciados | por unidade/tempo | limites por tier | Docs |

Modelos de Embeddings

| Modelo | Dimensão | Idioma | Destaque | Uso típico | Docs |

|---|---|---|---|---|---|

| text-embedding-3-large (OpenAI) | 3k+ | multi | alta precisão | RAG, clustering | Docs |

| multilingual-e5 (HF) | 768–1024 | multi | open-source | busca semântica OSS | Docs |

| Cohere embed v3 | 1024 | EN/Multilíngue | produtivo | RAG em escala | Docs |

Bancos de Dados Vetoriais

Quiz Interativo

Teste seus conhecimentos

Recursos Extras

Glossário

Consulte um glossário com mais de 100 termos técnicos na área de IA generativa e aprendizado de máquina. Inclui definições de acrônimos, métricas e algoritmos.

Painel de Atualizações

Acompanhe lançamentos e novidades da área consultando as documentações oficiais da OpenAI, Hugging Face, Model Context Protocol, LangChain e CrewAI.